I. Poincaré

„Miért van az, hogy annyi elme nem hajlandó megérteni a matematikát? Nincs ebben valami paradoxon? Hogy lehet az, hogy egy olyan tudomány, amely csak a logika alapelveire, például az ellentmondás elvére hivatkozik, arra, ami úgymond az értelmünk csontváza, arra, amit nem tudunk levetkőzni anélkül, hogy megszűnne a gondolkodásunk, és vannak emberek, akik ezt homályosnak találják! és még ők vannak többségben! Az, hogy képtelenek újat kitalálni, az rendben van, de hogy nem értik a nekik bemutatott demonstrációkat, hogy vakok maradnak, amikor olyan fényt mutatunk nekik, amely számunkra tiszta fénnyel ragyog, az egészen rendkívüli.

Pedig nem kell sok tanári tapasztalat ahhoz, hogy tudjuk, ezek a vak emberek semmiképpen sem kivételesek. Van itt egy probléma, amelyet nem könnyű megoldani, de amelynek foglalkoztatnia kell mindazokat, akik a tanításnak akarják szentelni magukat.”

Ezeket a sorokat Poincaré írta 1908-ban a „Tudomány és módszer” című kötetében. A probléma, amit itt megnevez, a helyes matematikai definíció problémája. Poincaré szerint a jó definíciónak két fontos tulajdonsága kell hogy legyen: le lehessen belőle vezetni matematikai szigorral az objektum kívánt (vagy megfigyelhető) tulajdonságait, de ugyanakkor intuitív legyen hogy egyrészt a tanításnál meg lehessen értetni a dolog lényegét és másrészt hogy ne szüljön szörnyeket. Az, hogy milyen szörnyekre gondol itt Poincaré, azt egy pár oldallal később írja le:

„A logika néha szörnyeket szül. Az elmúlt fél évszázadban rengeteg olyan bizarr függvény megjelenésének lehettünk tanúi, amelyek látszólag arra törekednek, hogy a lehető legkevésbé hasonlítsanak a célt szolgáló, becsületes függvényekre. Nincs többé folytonosság, vagy van folytonosság, de nincs derivált, és így tovább. Ráadásul logikai szempontból ezek a furcsa függvények a legáltalánosabbak; azok, amelyekkel anélkül találkozunk, hogy kerestük volna őket, csak speciális esetként jelennek meg….

A múltban, amikor feltaláltunk egy új függvényt, az valamilyen gyakorlati célt szolgált; ma már direkt azért találjuk fel őket, hogy megkérdőjelezzük apáink gondolkodását, és ez minden, amit valaha is kihozunk belőlük.”

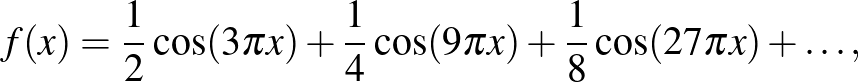

A szörny, amire Poincaré itt hivatkozott, 1872-ben született Karl Weierstrass, a híres berlini professzor egyik előadásán, és így néz ki:

illetve, általánosabban1

Ez a függvény, amelyről Weierstrass bebizonyította hogy folytonos, de sehol sem differenciálható, nagy port kavart, főleg az akkori matematika fellegvárában, Párizsban. Ennek két oka volt. Az egyik, hogy akkoriban a differenciál- és integrálszámítás (tehát a valós függvénytan) egyik alaptételének számított a híres francia matematikus és fizikus André-Marie Ampére tétele 1806-ból „théorème fondamental”, amely szerint minden folytonos függvény egy pontosan meghatározható kivételes és izolált halmazon kívül differenciálható („certaines valeurs particulières et isolées”). Ezt sok egyetemi könyvben és jegyzetben megtalálni a 19. században, bár egyes szerzők, pl. Weierstrass, hozzátette gondos előrelátással, hogy a függvény nem csak folytonos hanem szakaszonként monoton legyen. A másik ok bizonyára a francia-porosz háború volt, amelyet a franciák 1871-ben csúfosan elvesztettek. Tehát hogy egy porosz professzor még a francia tételeket is döntögeti, biztos szálka volt a franciák szemében. A híres Charles Hermite, akkoriban a Sorbonne egyetem professzora, a francia akadémia tagja és a francia becsületlégió nagytisztje, 1893-ban egy Stietjes-hez írt levélben ezt írta:

„Az Analízis az egyik kezével elveszi azt, amit a másikkal ad. Elborzadva és megdöbbenve fordulok el a folytonos függvények e siralmas csapásától, amelyeknek nincsenek deriváltjaik…”

Egyszóval nem voltak jó véleménnyel Weierstrass szörnyéről, és hasznát semmiképpen sem látták. Ugyanakkor, mint azt más kontextusból is ismerjük, Poincaré tévedései utólag majdnem hogy fontosabbnak nyilvánultak mint a helyes bizonyításai, és ebben az előadásban erről is van szó.

II. Hidrodinamika

A 20. század elején közismert mondás volt, hogy a hidrodinamikával foglalkozó kutatók társadalma két csoportra osztható: azok, akik a folyadékok olyan tulajdonságait észlelik amiket nem tudunk bizonyítani, és azok, akik a folyadékok olyan tulajdonságait bizonyítják, amiket nem tudunk észlelni. Tehát volt (és bizonyos fokig még mindig van) egyfajta disszonancia a

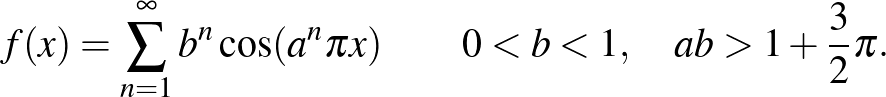

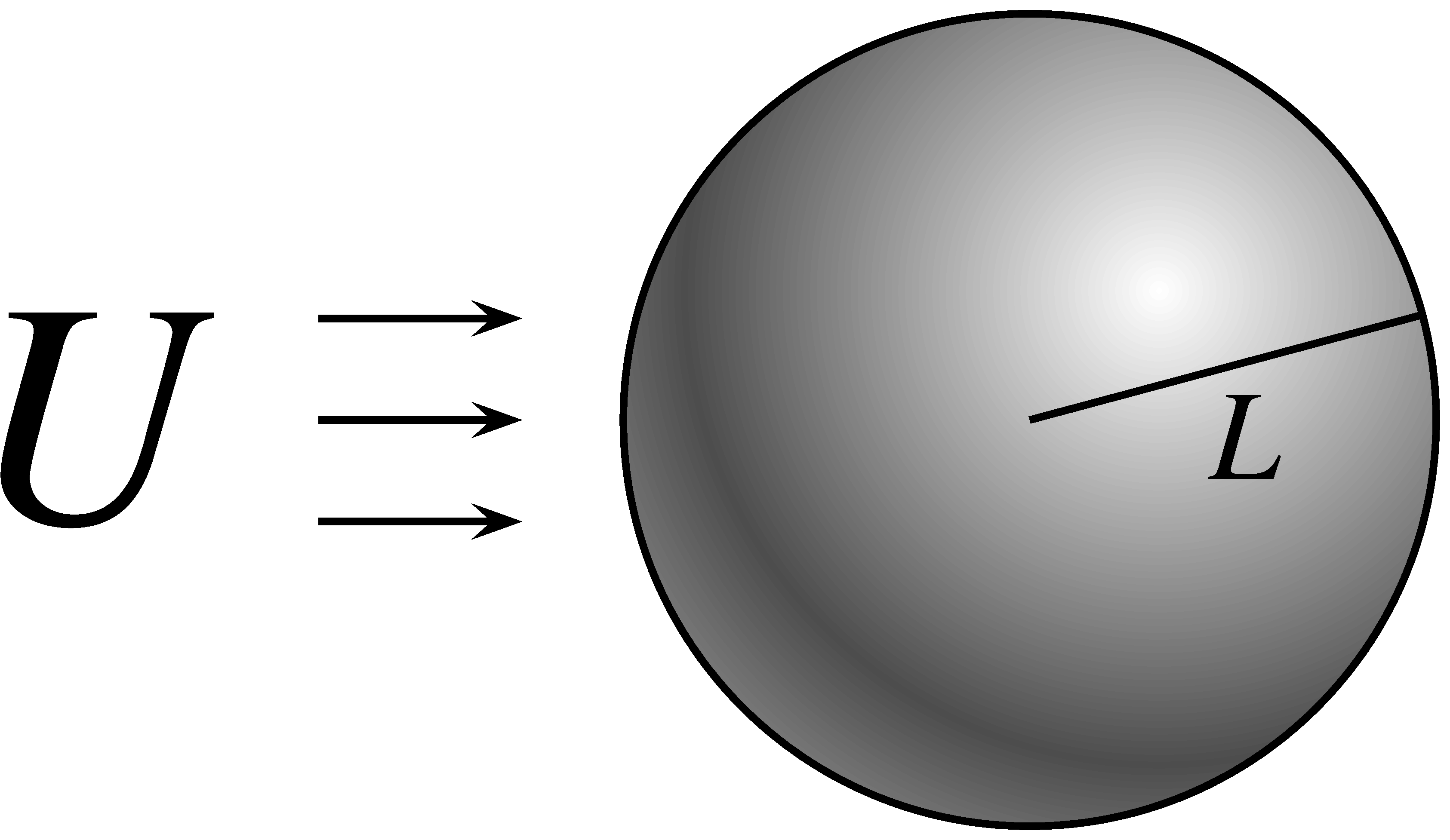

jelenségek és tulajdonságok között. Erre az egyik kedvenc példám a hidrodinamika egyik nagy klasszikus problémája: Mekkora az ellenálláserő, amely az egyenletes, stacionárius  -sűrűségű folyadékban

-sűrűségű folyadékban  sebességgel haladó

sebességgel haladó  sugarú gömbre hat?

sugarú gömbre hat?

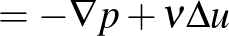

Ezzel már maga Newton foglalkozott, és a Principia-jában megtaláljuk a választ:

Ezt Newton egyszerűen úgy vezette le, hogy ha feltesszük, hogy  csak ettől a három paramétertől függhet, ez az egyetlen képlet, amelynek helyes a mértékegysége.

csak ettől a három paramétertől függhet, ez az egyetlen képlet, amelynek helyes a mértékegysége.

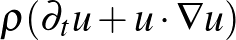

Ez a képlet nagyjából megfelel a valóságnak sok esetben, ezt számos kísérlettel lehet igazolni. De mi ezzel a baj? Az, hogy látszólag nem bizonyítható. Ezalatt azt értem, hogy a Newton törvényeket leíró kontinuum egyenletekből, a Navier–Stokes vagy az Euler-egyenletekből nem ez a képlet, hanem valami egész más következik:

|

|

|

|

|

Amennyiben a folyadék viszkozitása 0, d’Alembert bizonyította 1752-ben, hogy  . Ez nyilván paradoxon és a valóságnak ellentmond. D’Alembert eredményét Stokes általánosította 1851-ben viszkózus folyadékokra, amely szerint:

. Ez nyilván paradoxon és a valóságnak ellentmond. D’Alembert eredményét Stokes általánosította 1851-ben viszkózus folyadékokra, amely szerint:

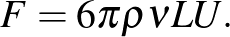

Stokes képlete is helyes bizonyos esetekben. Hogy Stokes-nak vagy Newtonnak van igaza, az attól függ, hogy mennyire turbulens a folyadék. Ezt egy dimenziómentes mérőszámmal, a Reynolds-számmal szokás kvantifikálni.

Ha  kicsi (kb. 1), akkor Stokes-nak van igaza. Ha

kicsi (kb. 1), akkor Stokes-nak van igaza. Ha  nagy (kb.

nagy (kb.  ), akkor Newtonnak. A

), akkor Newtonnak. A  soknak tűnik, de ez a tipikus Reynolds-szám pl. egy autónál városi közlekedésnél. Megfigyelhetjük, hogy ha a viszkozitás 0-hoz tart, akkor a Reynolds-szám divergál végtelenhez, tehát egyrészt Newton turbulens esetében vagyunk, másrészt az egyenletrendszer formálisan leegyszerűsödik az Euler-egyenletté, ahol viszont d’Alembert tétele érvényes. Ez a baj.

soknak tűnik, de ez a tipikus Reynolds-szám pl. egy autónál városi közlekedésnél. Megfigyelhetjük, hogy ha a viszkozitás 0-hoz tart, akkor a Reynolds-szám divergál végtelenhez, tehát egyrészt Newton turbulens esetében vagyunk, másrészt az egyenletrendszer formálisan leegyszerűsödik az Euler-egyenletté, ahol viszont d’Alembert tétele érvényes. Ez a baj.

III. Gyenge megoldások

A kulcskérdés az, hogy mit fogadunk el mint megoldás definíciója, és ehhez tudni kell hogy a

határátmenet egy szinguláris perturbáció.

Hogy ez mit jelent, azt Michael Berry írta le nagyon találóan:

Ha beleharapunk egy almába, és egy kukacot találunk benne, az elég kellemetlen felfedezés. De ha csak egy fél kukacot találunk, az még rosszabb; ha egy kukac egyharmadát, az még kellemetlenebb. Ugye minél kevesebb hányadát találjuk meg a kukacnak az első harapás után, annál többet ehettünk meg. Ugyanakkor, ha nincs egyáltalán kukac az almában a harapás után, akkor minden oké. Erre mondjuk azt, hogy a „kukachányad tart nullához” határérték szinguláris.

Ugyanez a szituáció áll fenn ha a Navier–Stokes-egyenletnél a viszkozitás nullához tart – illetve a Reynolds-szám tart végtelenhez. A probléma az, hogy az Euler-egyenletnek létezik sima megoldása, de ez a sima megoldás nem írja le a turbulens mozgást, amit a gömb körül, illetve a gömb mögött észlelünk. Tehát meg kell változtatni a megoldásfogalmat, itt jönnek a képbe a gyenge megoldások.

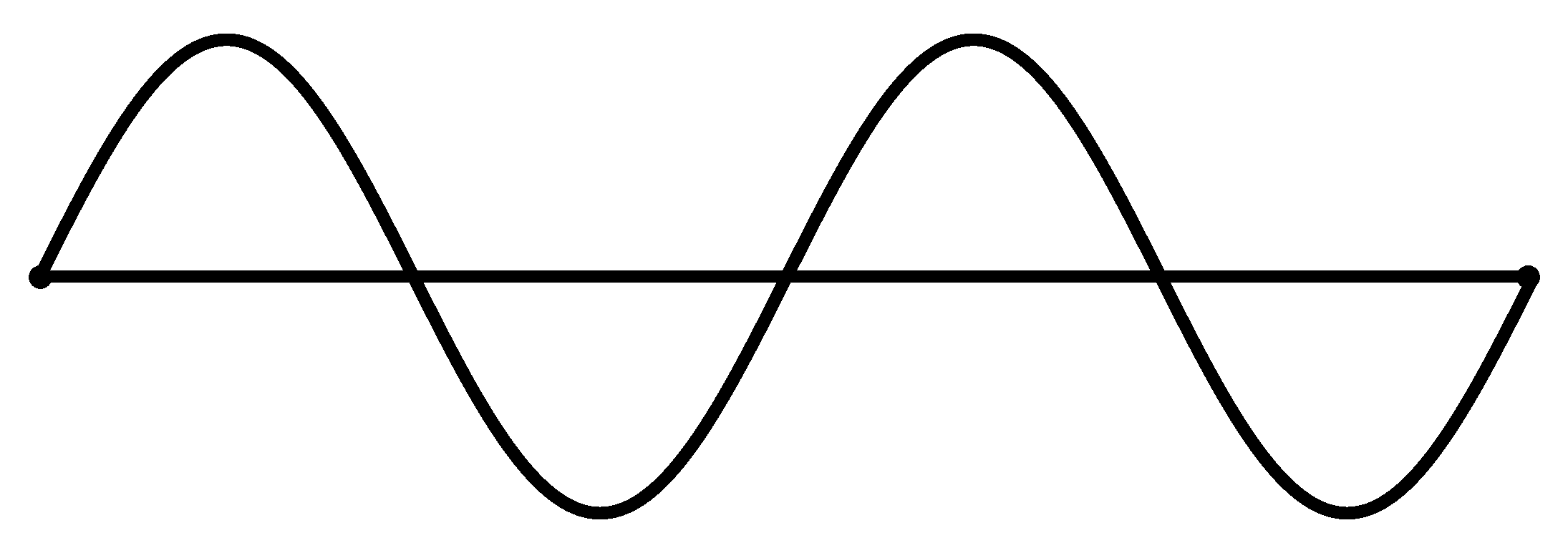

Bár azt hihetnénk, hogy a parciális differenciálegyenletek gyenge megoldáselmélete a huszadik században keletkezett a modern funkcionálanalízis születésével párhuzamosan, de igazából a gyenge megoldások története olyan régi, mint a parciális differenciálegyenleteké. Az első egyenletek egyike a kifeszített húr rezgését leíró lineáris hullámegyenlet,

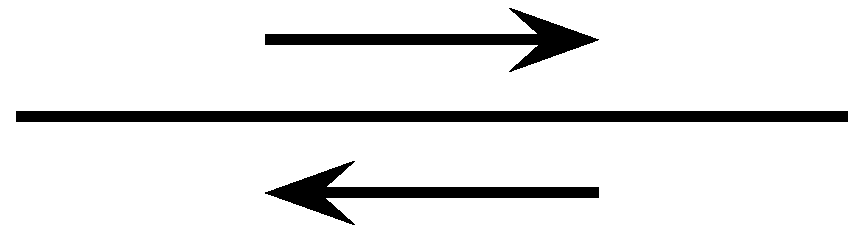

amelyet d’Alembert 1747-ben írt fel, és lényegében azt a fizikai tételt írja le, hogy a húrra ható függőleges erő (és ezáltal a gyorsulása) egyenesen arányos a húr görbületével. d’Alembert le is vezette ennek az egyenletnek az általános megoldását,

szóval az általános rezgőmozgás leírható mint két utazóhullám szuperpoziciója, az egyik  sebességgel jobbra, a másik

sebességgel jobbra, a másik  sebességgel balra tart. Itt egyből felmerült a kérdés, hogy ez a képlet hogyan értelmezhető, ha a két hullámot leíró

sebességgel balra tart. Itt egyből felmerült a kérdés, hogy ez a képlet hogyan értelmezhető, ha a két hullámot leíró  és

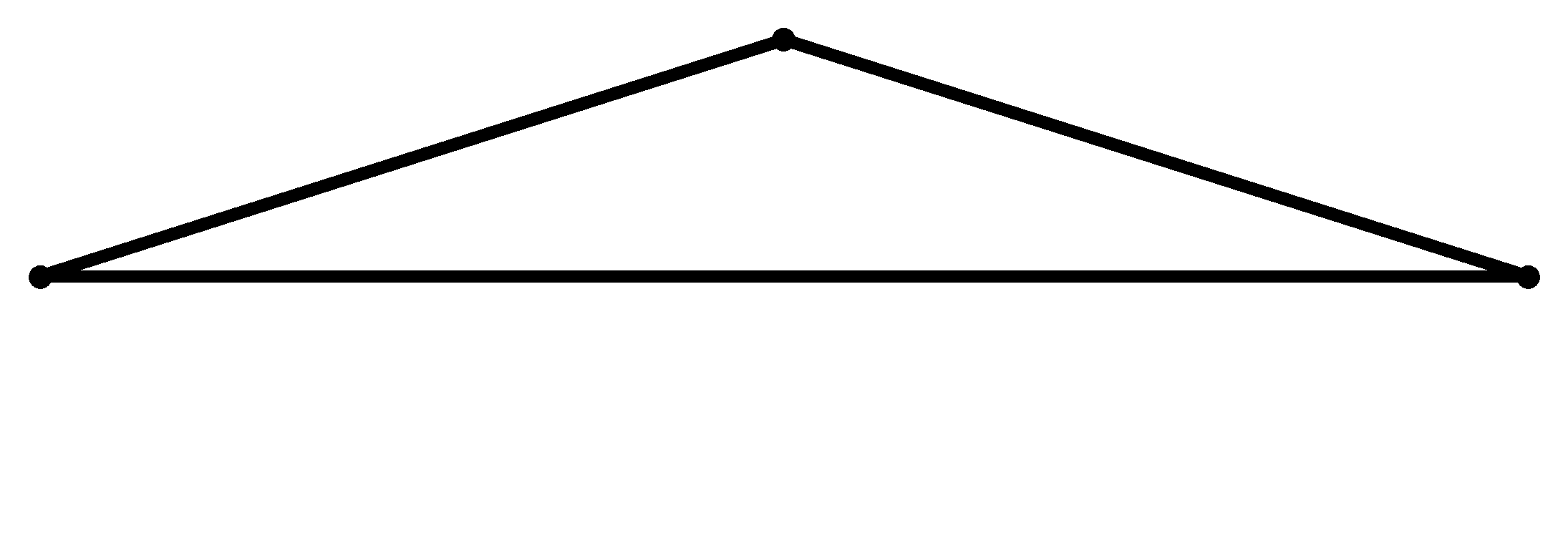

és  függvények nem deriválhatóak. d’Alembert ezt a lehetőséget egyszerűen kizárta, mert ugye a hullámegyenletben két deriváltat kell tudni értelmezni, viszont Euler azt állította hogy ebben az esetben is kell tudni értelmezni a megoldást. Kettejük között heves intellektuális vita alakult ki, amely arra összpontosult, hogy hogyan lehet egy tört vonal alakú kezdeti értéknél Newton törvényét értelmezni, hiszen a töréspontnál a görbület, így a húrra ható rugalmassági erő végtelen nagyságú.

függvények nem deriválhatóak. d’Alembert ezt a lehetőséget egyszerűen kizárta, mert ugye a hullámegyenletben két deriváltat kell tudni értelmezni, viszont Euler azt állította hogy ebben az esetben is kell tudni értelmezni a megoldást. Kettejük között heves intellektuális vita alakult ki, amely arra összpontosult, hogy hogyan lehet egy tört vonal alakú kezdeti értéknél Newton törvényét értelmezni, hiszen a töréspontnál a görbület, így a húrra ható rugalmassági erő végtelen nagyságú.

A vitának végül 1760-ban Lagrange vetett véget azzal az érvvel, hogy az erőviszonyokat és Newton második törvényét nem pontonként, hanem, mivel egy kontinuum-modellről van szó, infinitezimális intervallumokon kell tudni értelmezni. Tehát a görbületet kis delta-nagyságú intervallumokon kell átlagolni, ez megadja az átlagolt erőt, amely delta-nagyságú intervallumokra hat, és ha az ebből keletkező delta-átlagolt mozgásnak van egyértelmű  limesze, akkor ez a limesz az egyértelmű megoldás.

limesze, akkor ez a limesz az egyértelmű megoldás.

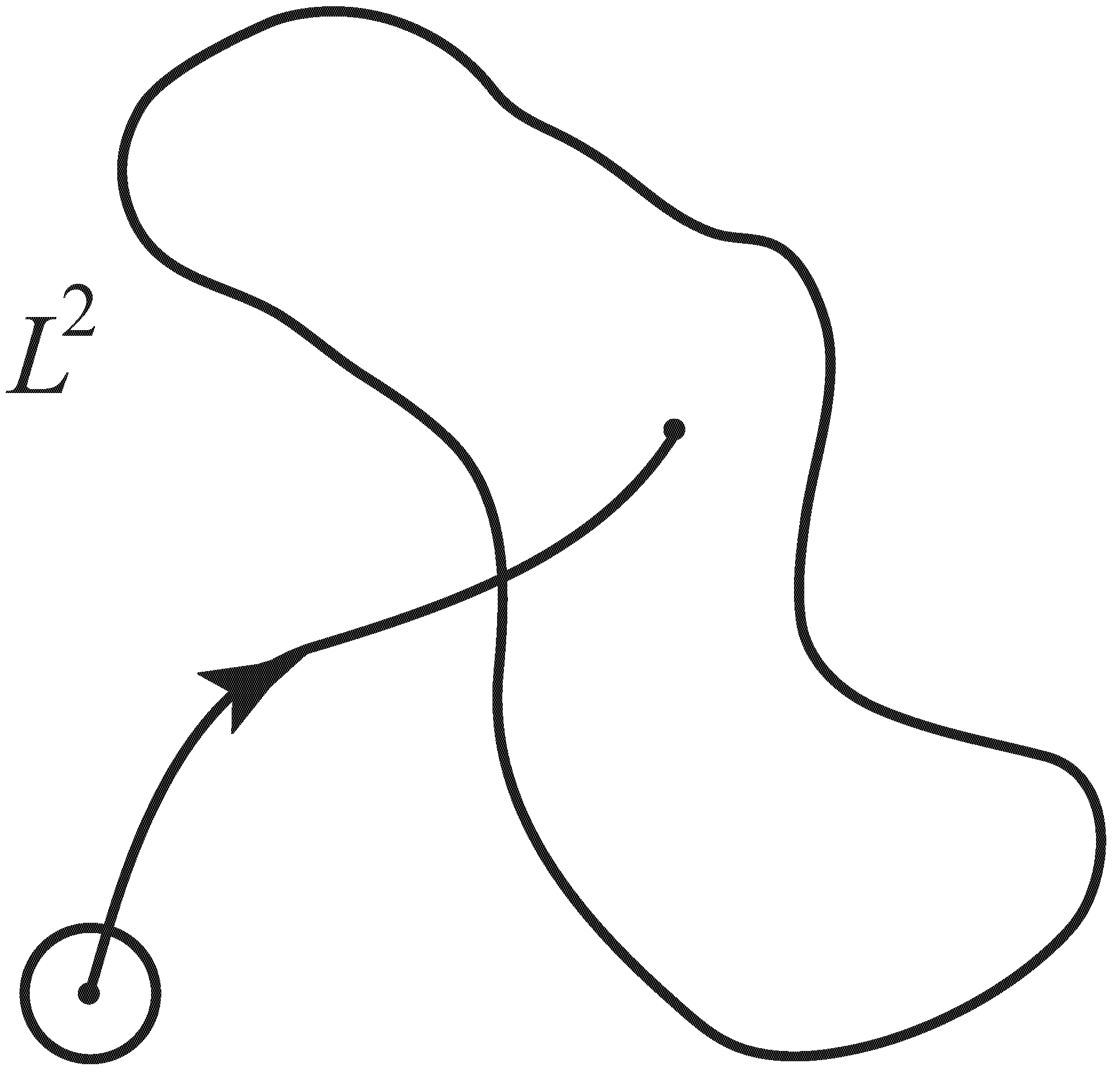

Ezzel tulajdonképpen Lagrange bevezette a gyenge megoldások elméletét, amit manapság disztribució-értelemben vett megoldásnak nevezünk. A Navier–Stokes-egyenlet esetében a gyenge megoldás exisztenciaelmélete sokkal bonyolultabb, ezt csak 1934-ben sikerült Jean Leray-nek megalkotnia. Mellesleg ezt a megoldásfogalmat Leray „solution turbulent”-nek nevezte.

Van még egy másik definíciója is a gyenge megoldásnak, és ez is a hullámegyenlettel kezdődött. Ha a húr két végét fixáljuk, akkor természetesebb elképzelni a húr mozgását mint sajátrezgések szuperpozicióját, nem pedig utazóhullámok szuperpoziciójaként. Így a Fourier sorfelbontáshoz jutunk, miszerint

és minden amplitúdó egy közönséges differenciálegyenletet kell hogy megoldjon:

Ez a megoldás akkor értelmezhető, ha a sor abszolút konvergál, de ebben az esetben a megoldás nem feltétlenül deriválható. Az Euler-egyenletre Lars Onsager alkalmazta ezt a megoldás-definiciót, erre még visszatérünk.

Azt is hozzáteszem, hogy ha más kikötést nem teszünk, ez a két definíciója a gyenge megoldásnak ekvivalens.

Mint említettem, a Navier–Stokes-egyenletre Leray dolgozta ki a gyenge megoldások exisztenciatételét, de unicitást nem tudott bizonyítani. A gyenge megoldások egyértelműsége mai napig megoldatlan probléma. Az Euler-egyenletre sokkal később sikerült gyenge megoldásokat konstruálni, először Vladimir Scheffernek sikerült 1993-ban. Viszont ami itt született, az megint egy szörny (Cedric Villani fogalmazása szerint): Scheffer bizonyította, hogy az Euler-egyenletnek létezik olyan gyenge megoldása, amely egy kezdeti időintervallumban 0, tehát a folyadék sebessége nulla, azután a folyadék egyszer csak el kezd magától mozogni, és egy még későbbi időintervallumban magától a folyadék megint megáll és a sebessége nulla. Nyilván egy olyan megoldásról van szó, ami fizikai szempontból semmiképpen sem értelmezhető. Tehát azzal, hogy a megoldásfogalmat általánosítottuk, átestünk a ló másik oldalára, és az új kérdés az hogy milyen plusz kikötésekkel tudnánk a gyenge megoldások közül a fizikailag értelmezhetőeket kiválasztani.

IV. Energiakaszkád

Ennél a pontnál vizsgáljuk meg újra a Fourier-soros definíciót. A hullámegyenletnél minden sajátrezgés amplitúdója egymástól függetlenül változott, és minden sajátrezgés kinetikus energiája külön-külön időben konstans volt – ezért volt könnyű dolgunk. Viszont a Navier–Stokes és az Euler-egyenlet nem lineáris, a nemlinearitás miatt a különböző sajátrezgések egymással kapcsolatban vannak, és egymásnak átadhatják a kinetikus energiájuk egy részét. Így egy energiakaszkád jön létre, ezt egy egyszerű modellel szeretném illusztrálni.

Képzeljünk el különböző méretű kerekeket, amelyek szabadon tudnak forogni. Ezek a kerekek szimbolizálják a különböző nagyságrendű Fourier-sajátrezgéseket, illetve folyadékáramlás esetében a különböző karakterisztikus méretű folyadékmozgásokat. A hullámegyenlet esetében minden kerék egymástól függetlenül forog, és mindegyiket külön erő forgatja. De a nemlinearitás miatt a Navier–Stokes és Euler-egyenleteknél van kapcsolat, ez itt legyen egy plusz áttétel és lánc, ami a szomszédos kerekeket összeköti. Mint egy bicikli végtelen sok kerékkel, mondhatjuk: Hilbert-bicikli.

Most képzeljünk el egy turbulens áramlást. Az első, amit észreveszünk turbulens áramlásnál, hogy részleteiben kaotikus és megismételhetetlen, de a mozgás statisztikája (pl. egy pontban vett sebesség változásainak disztribuciófüggvénye) időben eltolás-invariáns, más szóval stacionárius. Itt kézenfekvő a statisztikus fizika eszközeit bevetni, de figyelembe kell venni, hogy nem egy zárt rendszerről van szó, mert egy turbulens folyamot állandóan keverni kell, hogy mozgásban maradjon és állandóan kinetikus energiát veszít ugyanolyan arányban a belső súrlódás miatt. Neumann János szavaival élve itt a stacionárius állapotot nem az energia ekviparticiója, hanem a disszipáció ekvipartíciója írja le. Ez ezt meghatározó paraméter tehát az energiadisszipáció mértéke  . A turbulencia egyik empirikus alaptétele (sokan ezt a turbulencia nulladik tételének nevezik) az, hogy az energiadisszipáció mértéke nem függ a Reynolds-számtól (illetve a viszkozitástól).

. A turbulencia egyik empirikus alaptétele (sokan ezt a turbulencia nulladik tételének nevezik) az, hogy az energiadisszipáció mértéke nem függ a Reynolds-számtól (illetve a viszkozitástól).

A Hilbert-biciklin ezt úgy tudjuk modellezni, hogy pedált rakunk az első kerékre, és féket az utolsóra. A kérdés, hogy a  „turbulens limeszben” a stacionárius állapotban mekkora lesz az egyes kerekek kinetikus energiája. Ha feltesszük, hogy az

„turbulens limeszben” a stacionárius állapotban mekkora lesz az egyes kerekek kinetikus energiája. Ha feltesszük, hogy az  -sugarú kerék energiája csak az

-sugarú kerék energiája csak az  hossztól és

hossztól és  -tól függhet, ezt kapjuk:

-tól függhet, ezt kapjuk:

Ez egy variánsa a Kolmogorov-féle  tételnek (ami ennek a Fourier-transzformáltja). Mivel a kinetikus energia a sebesség négyzetével arányos, ez egy sebességfüggvénynek felel meg, amely kísértetiesen hasonlít Weierstrass szörnyére:

tételnek (ami ennek a Fourier-transzformáltja). Mivel a kinetikus energia a sebesség négyzetével arányos, ez egy sebességfüggvénynek felel meg, amely kísértetiesen hasonlít Weierstrass szörnyére:

Mivel a disszipáció mértéke független a viszkozitástól, a  limeszben olyan gyenge megoldásokat kell keresni az Euler-egyenlethez, amelyeknél az energia nem marad meg, pedig nincs külső erő – mert a fék infinitezimális és nem látni. Olyan ez, mint az infinitezimális kukac az almában. Onsager 1941-ben megfogalmazott sejtése pont erről szól, tehát hogy létezhetnek ilyen struktúrájú gyenge megoldások. Pontosabban, léteznek Hölder-folytonos de nem deriválható sebességfüggvények az

limeszben olyan gyenge megoldásokat kell keresni az Euler-egyenlethez, amelyeknél az energia nem marad meg, pedig nincs külső erő – mert a fék infinitezimális és nem látni. Olyan ez, mint az infinitezimális kukac az almában. Onsager 1941-ben megfogalmazott sejtése pont erről szól, tehát hogy létezhetnek ilyen struktúrájú gyenge megoldások. Pontosabban, léteznek Hölder-folytonos de nem deriválható sebességfüggvények az  exponensig, amelyeknél a kinetikus energia nem állandó,

exponensig, amelyeknél a kinetikus energia nem állandó,  exponens felett viszont a kinetikus energia szükségképpen állandó minden gyenge megoldásnál. Ezt kb. 5 éve sikerült igazolnunk.

exponens felett viszont a kinetikus energia szükségképpen állandó minden gyenge megoldásnál. Ezt kb. 5 éve sikerült igazolnunk.

A tételünknek viszont volt egy szépséghibája: az energia csökkenhet, de nőhet is, és a kettő között csak mesterségesen tudunk különbséget tenni. Ugyanis a módszerünk, a Hilbert-biciklin illusztrálva, a következő. Nem az első kerékre rakjuk a pedált, hanem a másodikra. Persze, mivel ez a kerék kisebb, ugyanakkor kinetikus energia generálásához gyorsabban kell tekerni. Ha a harmadikra rakjuk a pedált, akkor még gyorsabban és így tovább. Ad infinitum azt kapjuk, hogy az infinitezimálisan kis pedált tekerjük végtelen sebességgel, vagyis mintha Maxwell démonja tekerné Hilbert bicikliét.

És nemcsak tekerni hanem kontrázni is tud, persze. Ezt az egyszerű konstrukciós elvet Gromov konvex integrálás módszerével sikerült megvalósítanunk, de persze ez a Scheffer-féle szörnyekhez is vezetett.

V. A nulladik törvény

Egy turbulens áramlásnál, ha átlagolunk kis  -méretű tartományokon, akkor meg kellene kapnunk egy nagyobb, effektív viszkozitást, ami azon a skálán megfelel a disszipáció mértékének – ugyanúgy, ahogy Lagrange átlagolása megadta az effektív rugalmassági erőt a kifeszített húr kis

-méretű tartományokon, akkor meg kellene kapnunk egy nagyobb, effektív viszkozitást, ami azon a skálán megfelel a disszipáció mértékének – ugyanúgy, ahogy Lagrange átlagolása megadta az effektív rugalmassági erőt a kifeszített húr kis  -szakaszain. Ennek a matematikai módszere a homogenizálás. Egy tavaly ősszel megjelent cikkben a lipcsei kollegáimmal sikerült együtt alkalmaznunk a homogenizálást a konvex integrációval: bár még nem a Navier–Stokes-egyenletre, hanem a lineáris transzport-diffúzió egyenletre:

-szakaszain. Ennek a matematikai módszere a homogenizálás. Egy tavaly ősszel megjelent cikkben a lipcsei kollegáimmal sikerült együtt alkalmaznunk a homogenizálást a konvex integrációval: bár még nem a Navier–Stokes-egyenletre, hanem a lineáris transzport-diffúzió egyenletre:

ahol az  vektormező az Euler-egyenlet Onsager-féle gyenge megoldása. Ez az egyenlet azt írja le, hogy hogyan változik pl. egy, a turbulens áramlásba befecskendezett, anyag sűrűsége

vektormező az Euler-egyenlet Onsager-féle gyenge megoldása. Ez az egyenlet azt írja le, hogy hogyan változik pl. egy, a turbulens áramlásba befecskendezett, anyag sűrűsége  , ha ez egyrészt az áramlással együtt sodródik (transzport), másrészt kis kappa diffúziós együtthatóval terjed. A tételünk azt mondja ki, hogy az effektív diffúzió mértéke független a kappától:

, ha ez egyrészt az áramlással együtt sodródik (transzport), másrészt kis kappa diffúziós együtthatóval terjed. A tételünk azt mondja ki, hogy az effektív diffúzió mértéke független a kappától:

Itt a négyzetintegrál nem más mint az  sűrűség szórása. Enyhén túlzással ez egy matematikai bizonyítása a turbulencia nulladik törvényére, legalábbis a passzív transzport speciális esetében.

sűrűség szórása. Enyhén túlzással ez egy matematikai bizonyítása a turbulencia nulladik törvényére, legalábbis a passzív transzport speciális esetében.

VI. Pillangóhatás

Visszatérve a Scheffer-szörnyhöz, most szeretnék arra rámutatni, hogy ez a Scheffer-szörny, tehát a Maxwell-démon által hajtott Hilbert-bicikli, mégis hasznos kapcsolatban van valós jelenségekkel, de nem a hagyományos, Kolmogorov-féle energiakaszkáddal kapcsolatban, hanem egy úgynevezett inverz-energiakaszkáddal kapcsolatban. Ehhez kicsit ki kell térnem a Lorenz-féle pillangóhatásra.

Ennek a közismert változata, amely Edward Lorenz 1963-as cikkére van alapozva, azt jelenti, hogy véges dimenziós kaotikus dinamikus rendszereknél a apró (de véges) változtatása a kezdeti feltételeknek nagy változásokat okoz a későbbi dinamikában: „egy pillangó egyetlen szárnycsapása a Föld egyik oldalán tornádót idézhet elő a másikon”. Most én egy sokkal komolyabb pillangóhatásról szeretnék beszélni, ami Edward Lorenz kevésbé ismert 1969-es cikkére alapul. Itt nem alacsony-dimenziós dinamikus rendszerekről van szó, mint a klasszikus értelemben (az eredeti Lorenz-rendszer háromdimenziós), hanem magas-dimenziós rendszerekről.

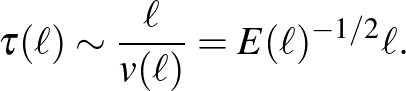

Lorenz ebben a cikkben bevezette a kiszámíthatósági tartomány, illetve kiszámíthatósági idő fogalmát. Ez alatt egy olyan időintervallumot kell érteni, amelyen belül, ha tipikus nagyságú mérési hibákat végzünk a kezdeti állapot meghatározásánál, akkor ez még elfogadható nagyságú hibát eredményez. Tehát ennyi ideig még egy elfogadható hibahatáron belül maradunk. A kiszámíthatósági idő nyilván arányos lesz egy adott skálán adott kinetikus energiával rendelkező dinamikus rendszer tipikus időskálájával, tehát

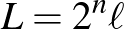

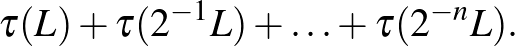

Vegyünk most egy olyan dinamikus rendszert, amely nagy szabadsági fokszámmal rendelkezik, tehát sok különböző skálán történik a dinamika – ilyen a föld alsó atmoszférájában a levegő áramlása. Tegyük fel azt is, hogy a dinamika nemlineáris, és minden skálán vett mozgás előbb-utóbb instabillá válik, ezután pedig lényegesen hat nagyobb skálákon is. Tehát pl. az  skálán vett mozgás

skálán vett mozgás  idő után instabillá válik és hatással lesz a

idő után instabillá válik és hatással lesz a  skálán történő dinamikára. Ebben az esetben azt kérdezhetjük, hogy egy, kis

skálán történő dinamikára. Ebben az esetben azt kérdezhetjük, hogy egy, kis  skálán vett hiba mennyi idő múlva van lényeges hatással a nagy

skálán vett hiba mennyi idő múlva van lényeges hatással a nagy  skálán történő dinamikára? A válasz nagyon egyszerű:

skálán történő dinamikára? A válasz nagyon egyszerű:

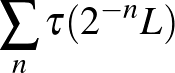

Lorenz rámutatott, hogy két lehetséges szituáció létezik, attól függően, hogy a

sor konvergál-e vagy sem. Ha konvergál, az azt jelenti, hogy bármilyen kis skálán vett hiba fix véges időn belül (ami arányos a  idővel) lényegesen befolyásolja a dinamikát. Ez a pillangóhatás erős változata! Ha viszont divergál, akkor minél kisebb skálán történik hiba, annál tovább tart, mire az a hiba látszani fog a nagy skálán. Ugyanez megfogalmazva a kiszámíthatósági idővel: ha a sor konvergál, akkor a rendszer kiszámíthatósági ideje felülről korlátos, bármilyen precíz méréseket is végzünk.

idővel) lényegesen befolyásolja a dinamikát. Ez a pillangóhatás erős változata! Ha viszont divergál, akkor minél kisebb skálán történik hiba, annál tovább tart, mire az a hiba látszani fog a nagy skálán. Ugyanez megfogalmazva a kiszámíthatósági idővel: ha a sor konvergál, akkor a rendszer kiszámíthatósági ideje felülről korlátos, bármilyen precíz méréseket is végzünk.

Mint láttuk, a Navier–Stokes turbulens áramlásában

tehát a fenti sor konvergál. Ha ezt a föld alsó atmoszféráján vett áramlásra alkalmazzuk, akkor a következő megdöbbentő eredményt kapjuk: ha mondjuk az 1000 km-es skálán vett kiszámíthatósági idő 3 nap (tipikus számok az európai meteorológiai előrejelzésnél), akkor a hasonlósági elv miatt az 1 km-es skálán vett kiszámíthatósági idő kb.  óra (ez pl. egy tipikus felhő mérete) és 1 m-es skálán vett kiszámíthatósági idő kb. fél perc. Tehát, ha sok pénzből elhatároznánk, hogy a meteorológiai előrejelzéshez a numerikus felbontást és az ehhez szolgáltatott mérési adathálózatot (amely jelenleg kb. 5–10 km felbontású) 1 m-es felbontásra finomítjuk, akkor ezzel a kiszámíthatósági időt, tehát az időt, amelyen belül a mérési és numerikus hibahatár elfogadható marad, csak kb. fél perccel javítanánk!

óra (ez pl. egy tipikus felhő mérete) és 1 m-es skálán vett kiszámíthatósági idő kb. fél perc. Tehát, ha sok pénzből elhatároznánk, hogy a meteorológiai előrejelzéshez a numerikus felbontást és az ehhez szolgáltatott mérési adathálózatot (amely jelenleg kb. 5–10 km felbontású) 1 m-es felbontásra finomítjuk, akkor ezzel a kiszámíthatósági időt, tehát az időt, amelyen belül a mérési és numerikus hibahatár elfogadható marad, csak kb. fél perccel javítanánk!

Persze nagyobb távolságokon (pl. nagyobb mint 10 km) a tipikus atmoszferikus dinamikát nem a 3D Navier–Stokes-egyenlet írja le, hanem 2D egyenletek, pl. a kvázi-geosztrófikus egyenlet (amely hasonlít a 2D Euler-egyenlethez) – az első numerikus időjárás-előrejelzésnél, amelyet Neumann János vezetésével végeztek a princetoni Institute for Advanced Study-ban 1950-ben, ezt az egyenletet használták. Ennél az egyenletnél az energiaspektrum más, itt

tehát itt Lorenz jobbik esetében vagyunk, ahol a sor divergál.

Tisztán matematikai szemszögből nézve Lorenz gondolatmenete azzal áll kapcsolatban, hogy a kezdetiérték-problémának létezik-e egyértelmű megoldása. Ehhez pedig nem feltétlenül a stacionárius állapot energiaspektruma mérvadó, hanem a kezdeti sebességmezőé. Itt egy érdekes példa a 2D Euler-egyenletnél fellépő Kelvin–Helmholtz instabilitás, amelynél a kezdeti sebességmező nem folytonos hanem van egy szakadása, ebből pedig következik hogy a kezdeti energiaspektrum nem a fenti, hanem

és ismét a konvergáló esetnél vagyunk. Azt ugyan nem nehéz igazolni, hogy ebben a speciális esetben végtelen sok gyenge megoldás létezik, viszont a kérdés megint az, hogy melyik megoldás-definíció szerint? Ugyanis ennél a végtelen sok gyenge megoldásnál (úgy mint a Scheffer-féle szörnynél) a sebességmező „csak” egy  függvény, tehát mérhető, és a négyzete integrálható, viszont a Kelvin–Helmholtz kezdeti sebességmező vorticitása egy véges mérték (ez majdnem azzal ekvivalens hogy a sebességmező korlátos változású), és azt tudjuk (ez Jean Delort francia matematikus híres cikke 1992-ből), hogy létezik olyan gyenge megoldás, amelynek ez a tulajdonsága megmarad. Továbbá, ez az a megoldástípus, amit akkor kapunk ha a sima megoldások terét lezárjuk, vagyis klasszikus megoldások limeszeit vesszük.

függvény, tehát mérhető, és a négyzete integrálható, viszont a Kelvin–Helmholtz kezdeti sebességmező vorticitása egy véges mérték (ez majdnem azzal ekvivalens hogy a sebességmező korlátos változású), és azt tudjuk (ez Jean Delort francia matematikus híres cikke 1992-ből), hogy létezik olyan gyenge megoldás, amelynek ez a tulajdonsága megmarad. Továbbá, ez az a megoldástípus, amit akkor kapunk ha a sima megoldások terét lezárjuk, vagyis klasszikus megoldások limeszeit vesszük.

A matematikai probléma tehát az, hogy tudjuk-e igazolni a Lorenz-féle erős pillangóhatást a Kelvin–Helmholtz instabilitásra, tehát azt, hogy ha a kezdeti sebesség a Kelvin–Helmholtz-nak tetszőlegesen közeli sima approximációja, akkor egységnyi idő alatt a Kelvin–Helmholtz stacionárius megoldástól, lényeges, egységnyi eltérést tapasztalunk. De ez már a jövő muzsikája.

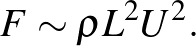

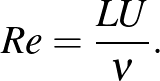

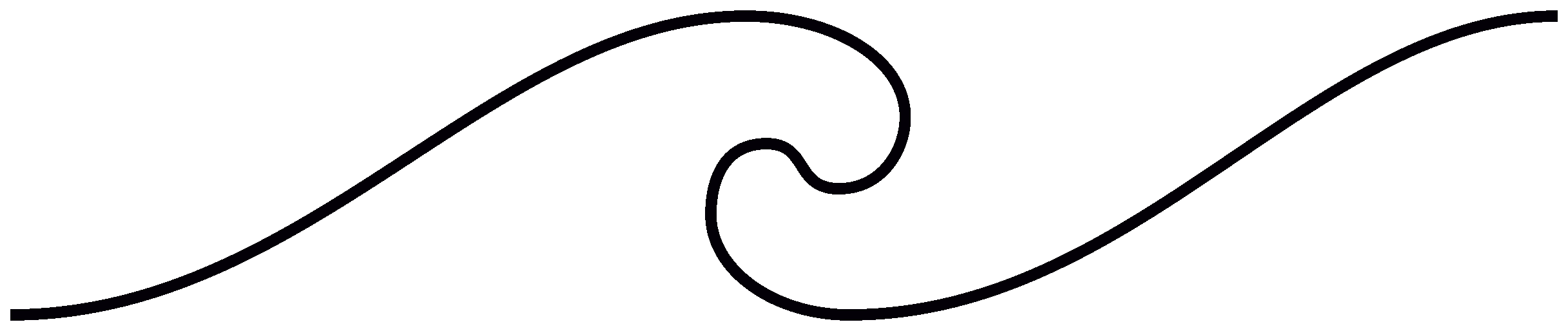

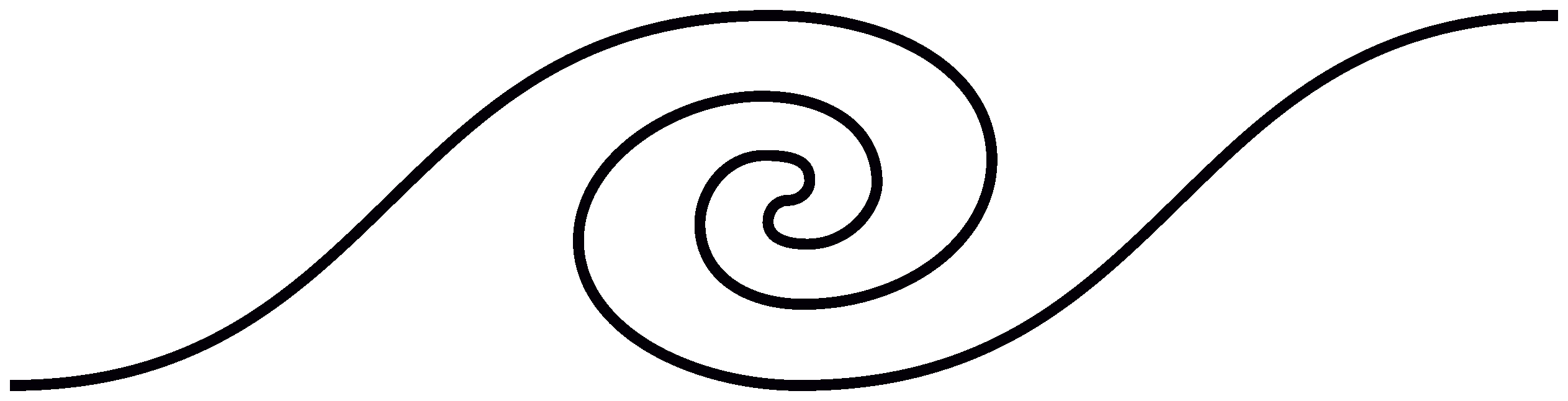

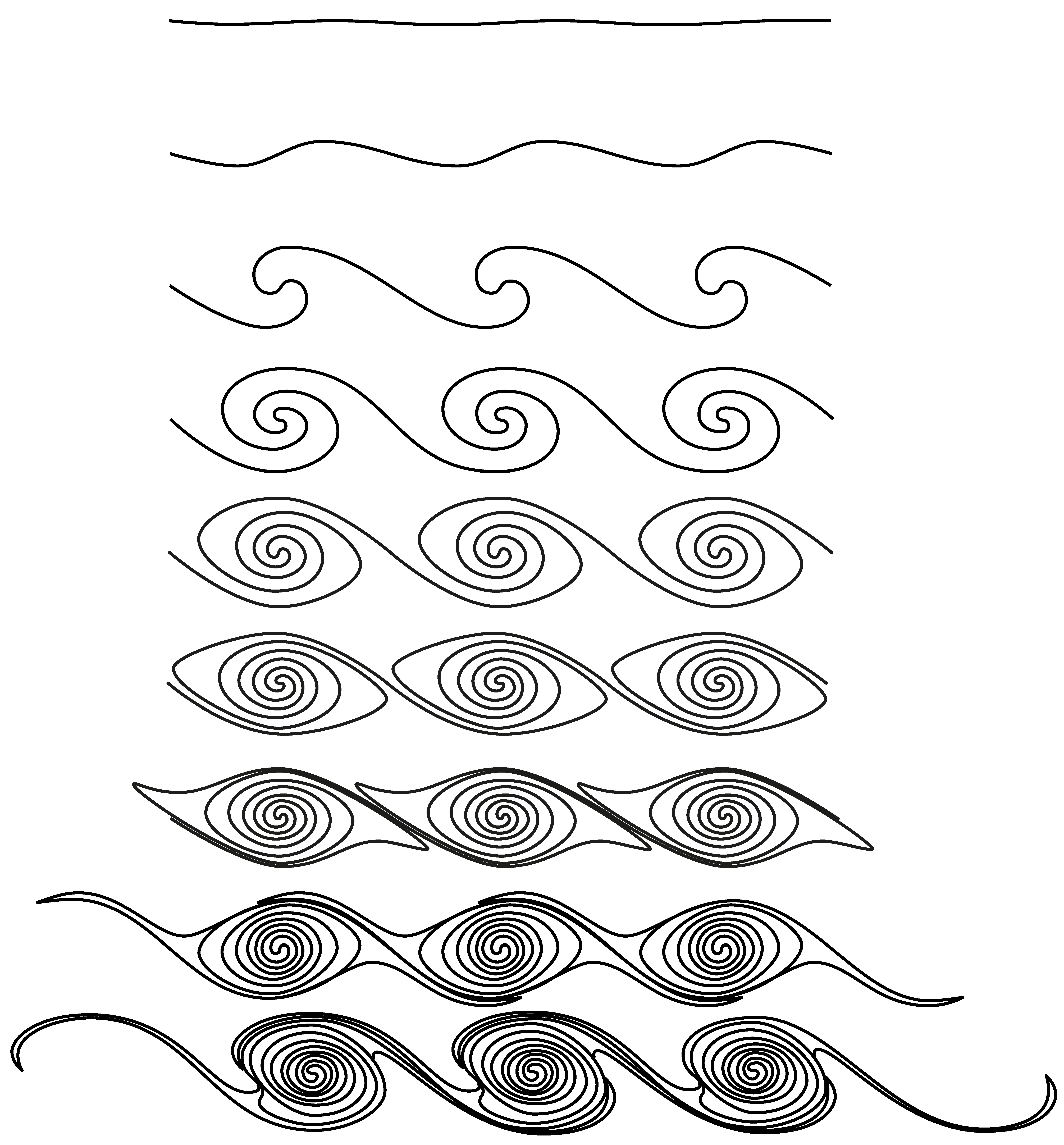

A Kelvin-Helmholtz instabilitás hatására kialakuló spirális örvények:

Lábjegyzet

- 1Aki figyel a részletekre, észre fogja venni hogy a fenti példa nem teljesíti Weierstrass kikötését az

és

és  paraméterekre. Viszont 1916-ban Hardy bizonyította, hogy elégséges az

paraméterekre. Viszont 1916-ban Hardy bizonyította, hogy elégséges az  feltétel is.

feltétel is.