Ön mit gondol? Melyik álhírcím és melyik nem az alábbiak közül?

- 53 éves nőt fiatalítottak 23 évessé egy új molekulával: megvan az örök fiatalság titka!

- A szürkehályogműtét csökkentheti a demencia kialakulásának kockázatát

- Csakis így fogyaszd! A Te konyhádban is biztosan van belőle, sokan imádják, de agyvelőgyulladást okozhat!

- Méhek az egészség szolgálatában – újabb kutatások a propoliszról és a mézről

- Csak a halált nem gyógyítja: cukorbaj, rák, agyvérzés, vérnyomás csökkentő, és még sok más betegség ellenszere

- Egy fehérje, amely véd a herpeszvírustól, de egyben Alzheimer-kórt is okoz?

Nem is olyan könnyű eldönteni! Eláruljuk: a páros számú címeket a PirulaKalauz.hu oldalán találtuk, ez a honlap több mint 12 éve közöl olyan írásokat, videókat, podcastokat, amelyek célja az ismeretterjesztés, a betegek tájékoztatása és az egészségértés javítása. (Hogy a páratlan számmal jelzett álhírcímek honnan származnak, azt inkább el sem áruljuk.) Mi segíthet abban, hogy eldöntsük: minek higgyünk és minek ne?

Az MTA Tudomány a Magyar Nyelvért Nemzeti Program Álhírek, áltudományos nézetek nyelvészeti azonosítása (2022–2026) című projektje keretében a nyelvészeti és tudományfilozófiai munkák mellett számítógépes eljárásokat fejlesztünk egészségügyi álhírek automatikus felismerésére. A legnagyobb megbízhatósággal az egészségügyi szövegekkel tanított mesterséges neuronháló alapú algoritmusunk dolgozik. Ennek használatához a megvizsgálandó szöveget be kell másolni a megfelelő ablakba. Ehhez képest kényelmesebb az okostelefonos alkalmazás, ami az aktuális képernyő szöveges tartalmát elemzi – a háttérben futva. Van keresőprogramba beépülő alkalmazásunk is, ez a teljes aktuális oldal alapján dönt. Az utóbbi két eljárásban az álhírekre jellemző, nyelvészek által megállapított jegyeket keresnek, és ezek alapján becsülik meg az adott szöveg álhír voltát. Hasznos tulajdonsága az okostelefonos és a keresőprogramba beépülő alkalmazásoknak, hogy azt is megmutatják, hogy mi alapján döntöttek. Ez hiányzik az elsőként említett, mesterséges neuronhálón alapuló megoldásból. A jelen cikk éppen ezérta betanított neuronháló eredményének részletesebb értelmezésével foglalkozik.

A projekt eredményei elérhetők a https://www.alhirdetektor.hu oldalon.

Itt – többek között – korábbi előadásokat lehet megnézni, továbbá a kifejlesztett okostelefonos álhírkereső alkalmazást, a böngészőbe beépülő eljárást, és a mesterséges neuronháló-alapú eszközt is le lehet tölteni.

A gépi tanulásról általában

A felügyelt gépi tanulási feladatok megoldása során olyan modellek létrehozását célozzuk meg, amelyek a modellezni kívánt jelenség minél nagyobb pontosságú előrejelzésére képesek a bemenetet jelentő inputjellemzők függvényében. Álhírfelismerő alkalmazásunkban maguk a szövegek képezik az inputot, a modelltől elvárt kimenet pedig azok álhír voltára vonatkozik. A modell tulajdonképpen egy olyan függvényként fogható fel, amely bemenetül szavak sorozatát várja, kimenetül pedig egy igenlő vagy nemleges választ szolgáltat, megítélve, hogy az adott hír álhír-e vagy se.

Ahhoz, hogy a modellünket jelentő függvény minél több inputon a szakértők döntésével megegyező kimenetet produkáljon, a modell ún. felügyelt tanítását kell elvégezzük. A felügyelt tanítás során bemenetek és elvárt kimenetek párosainak gyűjteményét bocsátjuk a modell tanítását végző optimalizációs eljárás rendelkezésére.

Az optimalizációs eljárás célja, hogy minimalizálja a rendelkezésére bocsátott minta (az ún. tanítóhalmaz) elemeihez a modellt jelentő függvény kiszámításával meghatározható valószínűsített kimenet, illetve a szakértők által ezekhez az elemekhez rendelt, elvártnak tekintett kimenet közötti eltérés nagyságát. A tanítóhalmaz elemein vétett hiba alapján a tanulásért felelős optimalizációs eljárás fokozatosan finomítani igyekszik a modell viselkedését, hogy annak hibája minél kisebbé váljon.

Ahhoz, hogy egy modell valódi gyakorlati haszonnal bírjon, fontos szempont, hogy jó általánosítóképességgel rendelkezzen, vagyis, hogy a modell megbízható döntései ne korlátozódjanak a tanítóhalmazban szereplő inputokra. A modellek ezen tulajdonságának mérésére használatos a tanítóhalmazban található elemekkel át nem fedő, ún. tesztelési halmaz, amellyel egy közelítést kaphatunk arra, hogy a modell milyen jó általánosítóképességgel bír. Amennyiben a modellünk megbízható döntéseket képes hozni a tanítóhalmazban szereplő esetekre, viszont gyenge a tanítóhalmazon kívüli adatokra vonatkozó pontossága, úgy túltanulásról beszélünk.

A túltanulás elkerülésén kívül a modellek működésének egy másik kívánatos tulajdonsága az, hogy a döntéshozatal a bemeneti értékek (más néven jellemzők) és a modellezett jellemzők közötti valódi ok-okozati összefüggések, és ne pedig a jellemzők és a célváltozó között esetlegesen fönnálló, valódi okozatiságot nélkülöző korrelációk alapján történjen. Ennek megítélése azonban nehéz feladat, tekintettel arra, hogy a manapság alkalmazott modellek a bemeneti változók és a kimenet kiszámítása során olyan sokszorosan összetett, nemlineáris műveleteket végeznek el, amelyek megnehezítik az egyes jellemzők végső döntéshozatalra gyakorolt hatásának közvetlen megítélését.

A transzformer architektúra használatáról röviden

A nyelvfeldolgozás területén nagy népszerűségnek örvendő, és az álhírfelismerő eljárásunk alapját is képző transzformer neurális architektúra hatékonyságát első ízben a gépi fordítási feladaton demonstrálták, bevezetését követően pedig számos további területen vált megkerülhetetlen technológiává: mára a természetesnyelv-feldolgozás (Natural Language Processing, röviden: NLP) és a mesterséges intelligencia (MI) egyéb területein (pl. képfeldolgozás, beszédtechnológia) is komoly minőségi javulásokat hozott.

A transzformer architektúrával történő feladatmegoldás egyik jellegzetes módja az ún. transzfertanulás. Ennek során a végső soron megoldani kívánt feladatra történő felügyelt tanulási folyamatot finomhangolásnak nevezzük. A finomhangolás a felügyelt tanulásnak azon speciális esete, ami nem egy teljesen betanítatlan, hanem egy ún. előtanítási fázison már átesett hálón történik. Az előtanítás még nem a közvetlenül megoldani kívánt (esetünkben álhírfelismerési) végalkalmazási feladatra vonatkozó, hanem annál sokkal általánosabb – ugyanakkor a végső feladat megoldása során vélhetően hasznos tudást biztosító – feladat tekintetében történik.

Ez az általános előtanítási feladat a szövegosztályozási problémák esetén az ún. nyelvi modellezés, amely során a neurális modellnek a szándékosan hiányossá tett szövegek kiegészítésének a feladatát kell minél nagyobb hatékonysággal elsajátítania. Ez az előtanítási feladat nem kell, hogy a célalkalmazás szakértői véleményekkel ellátott szövegeire korlátozódjon, tetszőleges, a vizsgálni kívánt nyelven írt szövegek alkalmasak ennek a tanulási feladatnak az elvégzésére. Éppen emiatt, a modell finomhangolására használt adatnál nagyságrendekkel nagyobb mennyiségben, költséges szakértői tudás fölhasználása nélkül elvégezhető ez, a modellnek a nyelv modellezésével kapcsolatos általános képességeit kialakító feladat.

Ez az általános képesség még közvetlenül nem alkalmazható (pl. álhírfelismerési) célfeladatok ellátására, ugyanakkor ez az előzetesen szerzett tudás, hatékony segítséget képes nyújtani az ezt követő finomhangolási fázis során elsajátítandó képességek kialakításában. Ahhoz hasonlóan, ahogy az aritmetikai alapműveletek elsajátítása önmagában nem vértez föl senkit könyvelői képességekkel, sokkal gyorsabban képes könyvelővé válni az, aki már birtokolja az alapműveletek elvégzésének képességét. A transzformer modellek működésének tekintetében a nyelvi modellezésre fókuszáló fázis felel meg az aritmetikai műveletek elsajátításának, míg a specializált (esetünkben álhírfelismerési) tudás elsajátítására fókuszáló finomhangolási fázist pedig – az aritmetikai műveletekre (is) alapozó – könyvelői szaktudás elsajátításának feleltethetjük meg.

Az ilyen módon használt mesterséges neurális hálók óriási népszerűségre tettek szert, amit annak köszönhetnek, hogy kellő mennyiségű finomhangolásra fordítható tanítóadat rendelkezésre állása esetén komplex mintázatok feltárására képes modelleket hozhatunk létre. Segítségükkel – egyebek mellett – nem triviális szövegosztályozási feladatok magas pontosságon kivitelezett automatizált elvégzése válik lehetővé az előzőekben bemutatott finomhangolási lépés elvégzését követően.

A finomhangolásos paradigma használata feltételezi egy, a feldolgozni kívánt nyelv modellezésével kapcsolatos előtanításon már átesett modell meglétét. Az ilyen modellek előállítása kifejezetten magas költségű, aminek megfizetésére azonban szerencsére csupán egyszer van szükség, ezt követően tetszőlegesen sok célfeladatra történő finomhangolás elvégezhető ugyanabból az előtanított modellből kiindulva, az előtanításra fordított erőforrásköltségek töredékéért. A magyar nyelv feldolgozására létrehozott, az előtanítás költséges fázisán már átesett modellből több is létezik, amelyek közül projektünk megvalósítása során az ezen a linken keresztül szabadon elérhető modelleket használtuk föl.

A fekete doboz és az interpretálhatóság fontossága

A transzformer modellek a szövegeket az ún. kétirányú figyelmi mechanizmus használatával dolgozzák föl, ami a teljes szövegkontextusra való érzékenységből adódóan a finom nyelvi árnyalatok figyelembevételét is lehetővé teszi, és ami jelentős javulást hozott a legtöbb NLP feladat megoldásában. Ezek a modellek azonban többszáz millió, vagy akár milliárd paraméterből állnak, ami a modell emberi értelmezhetőségének komoly gátat szab.

Emiatt a transzformeralapú szövegosztályozás, bár rendkívül hatékony és pontos, gyakran fekete dobozként működik. Ez azt jelenti, hogy miközben kiválóan képes feladatokat megoldani, nehézkes annak pontos megítélése, hogy az inputnak, illetve a betanított háló mely paramétereinek volt a legnagyobb jelentősége az egyes döntések meghozatala során, holott mindez növelni lenne képes a felhasználók bizalmát és az egyes döntések elfogadását, különösen egy olyan fontos területen, mint amilyen az álhírek felismerése is. Ha tudjuk, hogy mely szavak, frázisok vagy éppen mondatok állnak a modell döntéshozatalának fókuszában, könnyebben ellenőrizhetővé válik az is, hogy a modell logikus alapon – és nem pedig valamilyen felszínes, az előrejelezni kívánt változóval valódi oksági viszonyba nem hozható módon – hozza-e meg döntéseit.

Az interpretálhatóság segítségünkre lehet továbbá a modell hibáinak azonosításában és kijavításában. Ha egy modell tévesen osztályoz egy szöveget, az interpretálható magyarázat feltárhatja a probléma gyökerét. A modellek döntéshozatalának interpretálhatóságát segítő módszerek egyúttal a szabályozási megfelelés szempontjából is fontosak lehetnek, mivel mára számos iparágban előírás, hogy a mesterséges intelligencia rendszerek döntései átláthatók és magyarázhatók legyenek. Összességében tehát az interpretálhatóság nem csupán egy technikai kihívás, hanem alapvető szükséglet az MI modellek, és így a transzformeralapú szövegosztályozás felelősségteljes és megbízható alkalmazásához.

A SHAP-érték

A SHAP-módszer (SHapley Additive exPlanations) egy játékelméleti alapokon nyugvó módszer, amelynek célja, hogy megmagyarázza valamely gépi tanulási modell egyedi előrejelzéseit. A módszer alapját a közgazdasági Nobel-díjjal jutalmazott Lloyd Shapley nevéhez fűződő Shapley-értékek koncepciója adja.

A Shapley-érték megértéséhez képzeljünk el egy kooperatív többszemélyes játékot, ahol a játékosok együttesen dolgoznak egy célért, és a végén el kell osztaniuk a közösen megszerzett nyereményt. A Shapley-érték egy méltányos módszert ad arra, hogy megbecsüljük, az egyes játékosok milyen mértékben járultak hozzá a végső eredmény eléréséhez. A SHAP ezt a logikát ülteti át a felügyelt gépi tanulás világába. Itt a „játék” a modell előrejelzése, a „játékosok” pedig a bemeneti jellemzők, amelyek a szöveges adatok esetében a szavakat (vagy szótöredékeket) jelentik. A SHAP tehát azt számítja ki, hogy az egyes szavak mekkora „hozzájárulást” adtak a modell végső döntéséhez, például egy szöveg álhírként történő azonosításához.

A SHAP-módszer egyik legnagyobb előnye, hogy modell-agnosztikus, azaz elvileg bármilyen típusú modellre alkalmazható, a legegyszerűbb lineáris regressziótól a legbonyolultabb neurális hálózatokig. Továbbá lokális magyarázatokat ad, ami azt jelenti, hogy egy-egy konkrét előrejelzést képes részletesen megvilágítani.

Amikor a SHAP-ot egy finomhangoláson átesett transzformer modell döntésének jobb megértésére használjuk, akkor a módszer azt vizsgálja, hogy az egyes szövegrészek hogyan befolyásolják a modell kimeneti valószínűségét.

A folyamat leegyszerűsítve a következőképpen zajlik: a SHAP különböző variációkat hoz létre a bemeneti szövegből úgy, hogy egyes szavakat ideiglenesen „eltávolít” vagy semlegesít. Ezután megfigyeli, hogy ezen szavak hiánya hogyan változtatja meg a modell előrejelzését, majd ezen változások elemzésével a SHAP képes minden egyes szóra egy ún. SHAP-értéket számítani.

- A pozitív SHAP-érték azt jelzi, hogy a szó a modell döntését az adott kimeneti osztály (pl. „álhír” minősítés) felé tolta.

- A negatív SHAP-érték azt mutatja, hogy a szó a döntés ellen hatott, vagyis egy másik osztály (pl. „valós hír”) irányába vitte az előrejelzést.

Például egy – az emberi döntéshozatallal összhangban működő – álhírfelismerő modell esetében azt várnánk, hogy az elhallgatott igazság kifejezés magas pozitív SHAP-értéket kapjon egy álhír elemzésekor, míg a kötő- és funkciószavak jóval kisebb SHAP-értékben részesüljenek.

A SHAP-értékek vizualizációja

A SHAP-értékek önmagukban csak számok, amelyek befogadását vizualizációs eszközök segítségével tehetjük igazán kifejezővé. Ezek a vizualizációk rendkívül hasznosak a modell működésének jobb megértésében, illetve a modell működésében rejlő hibák feltérképezésében is. Ha a modell egyértelműen rossz szavakra vagy irreleváns információkra alapozza a döntését, az a SHAP-ábrákon láthatóvá válik.

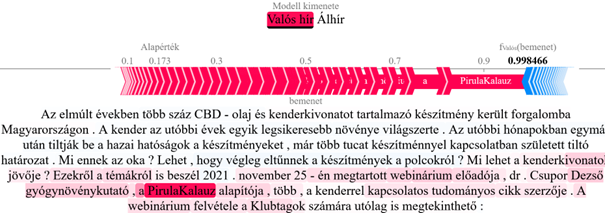

Az alábbiakban egy valódi és egy álhír mentén demonstráljuk a SHAP-értékekben rejlő vizualizációs lehetőségeket. Az 1. ábrán jól látszik, hogy a magas megbízhatóságú PirulaKalauzra történő hivatkozás nagy mértékben növelte az adott hír valós hírként való megítélését.

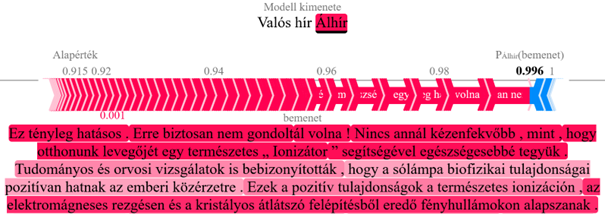

A 2. ábrán egy olyan eset látható, amikor a modell nagy bizonyossággal, valamint a szakértői jelöléssel összhangban álhírként jelölt egy szöveget. Azt, hogy a szöveg mely részének mekkora hozzájárulása volt a végsőnek meghatározott címke kialakulásában, az egyes szövegrészek színezése mutatja meg számunkra. Jól látszik, hogy a szöveg elején található túlzó és figyelemfelkeltő szövegrészeknek nagyobb, míg a sólámpák pozitív határait taglaló, mérsékeltebb tónusú mondatnak kisebb szerepe volt a modell végső döntésének meghozatalában.

A SHAP használatával kapcsolatos kihívások és korlátok

Bár a SHAP egy hatékony eszköz a modell döntéshozatalát befolyásoló tényezők megértésében, fontos tisztában lenni a módszertan korlátaival is, különösen a transzformer architektúrát használó modellek esetében.

A legfontosabb korlátozó tényező a SHAP-értékek pontos kiszámításával kapcsolatban, hogy az rendkívül számításigényes lehet, így nagy adathalmazok és komplex modellek esetén a folyamat gyorsítása érdekében érdemes lehet különböző közelítő eljárások használatára támaszkodni.

A SHAP-eljárás továbbá azzal a feltételezéssel él, hogy a bemeneti jellemzők (szavak) függetlenek egymástól. A természetes nyelvhasználatban azonban a szavak erősen függnek a kontextustól, ami torzító hatást fejthet ki az eredményekre nézve.

Végezetül a neurális modellek nem konkrét szavak, hanem szótöredékek sorozataként tekintenek a bemenetre. Ez azt jelenti, hogy egyetlen szó több szótöredékből is állhat a modellben történő feldolgozás szempontjából, ami megnehezítheti az eredeti szavak a SHAP-értékének meghatározását.

Összefoglalás

A transzformer-alapú nyelvi modellek hatalmas lehetőségeket rejtenek, de „fekete doboz”-természetük gátat szabhat széleskörű és biztonságos elterjedésüknek. A SHAP-módszer egy könnyen értelmezhető eszközt ad a kezünkbe, amellyel bepillantást nyerhetünk ezen komplex rendszerek döntési folyamataiba. Azáltal, hogy képes lebontani egy előrejelzést az azt alkotó elemek hozzájárulására, a SHAP segít a hibakeresésben, a modell torzításainak azonosításában, és végső soron növeli a mesterséges intelligenciával szembeni bizalmat. Bár megvannak a maga korlátjai, a SHAP és a hozzá hasonló magyarázhatósági technikák hasznos eszközt biztosítanak az MI-rendszerek átláthatóbbá és megbízhatóbá tételéhez.

Köszönetnyilvánítás

A tanulmány az MTA Tudomány a Magyar Nyelvért Nemzeti Program Álhírek, áltudományos nézetek nyelvészeti azonosítása (2022–2026) című projektje keretében készült.

Irodalom

Berend Gábor, Csendes Tibor és Németh T. Enikő: Álhírek felismerése nyelvi modellek segítségével. In: Nyest.hu. (2024), https://www.nyest.hu/hirek/alhirek-felsimerese-nyelvi-modellek-segitsegevel

Csendes Tibor, Berend Gábor és Németh T. Enikő: Egészségügyi álhírkereső eljárások informatikai megoldásai. Magyar Tudomány 185 (2024) 11, 1457–1464, https://mersz.hu/object/matud202411_f110312_i1

Maga Balázs és Virág Fausztin Asztrik: Nagy nyelvi modellek: a mesterséges intelligencia beszélni tanul. https://archiv.ematlap.hu/tudomany-tortenet-2026/1537-nagy-nyelvi-modellek-a-mesterseges-intelligencia-beszelni-tanul

Berend Gábor

egyetemi docens, SZTE Informatikai Intézet

Csendes Tibor

egyetemi tanár, SZTE Informatikai Intézet és

Pannon Egyetem Műszaki Informatikai Kar

Gencsi Mihály

doktorandusz, egyetemi tanársegéd, SZTE Informatikai Intézet

Németh T. Enikő

egyetemi tanár, SZTE Magyar Nyelvi és Irodalmi Intézet